ビッグデータとデータマイニングの技術が進化しつつあります。

古くはオバマ大統領選挙のとき。

データマイニングは、情報処理という技術が生まれた当時からあるものです。日々蓄積していく情報を分析整理し、情報を発掘することで新しい価値を生み出す仕組みです。

2010年代に入って、この技術はビッグデータという言葉とともに広く知られるようになりました。2008年のアメリカ大統領選挙では、オバマ陣営がビッグデータによるデータマイニングを行い、効率的かつ効果的に支持者を広げ寄付金を獲得していったことでも知られています。SNSなどで交わされる膨大な会話を分析し、国民の関心をたくみに分析して自分への投票行為という究極の価値へと転換していったのです。

データマイニングの活用によってこれまで考えもしなかったような新しい価値が発見でき、マーケティングでは新しい購買活動へとつなげられるメリットがあります。

データマイニングは金脈を掘り起こすようなものです。そのためには膨大なデータから仮説を発見しなくてはなりません。

例えば、大統領選挙の例でいくと「熱心な民主党支持者のジョージクルーニーと会食すれば西海岸の中高年女性からの寄付が40%増加する」といったものが仮説です。

仮説を立てるには多くの予測から生み出されます。例えばテレビの視聴率から。映画の動員数から。Twitterでのコメント投稿から、Facebookでの投稿の数からなど、多くの情報からそれらの予測が行えます。

分類することも重要です。同じく大統領選挙の例でいくと、件名やタイトルを変えてランダムに寄付を募るメールを一定数に送信します。そして戻ってきた情報を分析・分類し、寄付が多かった件名やタイトルに絞って、さらに大規模に展開していくのです。件名ごと、タイトルごと、アプローチ方法ごとに細かくターゲットを分類し、優良な組み合わせを見つけたら今後は他の可能性は一切捨てて、ひとつに絞って高い効果を挙げるのです。

例えば激戦区の州でもっとも投票率が高い人は、週末はどのような過ごし方をするのか、どのような家族構成なのかを分析し、関連付けます。これによって膨大なデータから、絞るべきターゲットが浮き上がります。似たような趣味趣向、パターン、グループ分けによって、より強いアプローチを行うことができます。例えばオバマ陣営は激戦区であるオハイオ州の有権者データを分析し、5万通り以上のシミュレーションを行って、選挙戦に望んだと報道されています。

効果的にデータマイニングを行うためには、情報の母集団は多ければ多いほどいいのです。少ない事例からでは分析ができません。最低でも10万件以上の情報が必須となります。時間をかけて広範囲から集めたデータによって、母集団が多いほど効果的な解析ができるようになります。データマイニングは煩雑で整理されていない情報の中から金脈を見つける行為です。データ収集を行った後は分析に時間をかけ、これまで思いもよらなかったような情報をたぐりよせることが可能になります。

また顧客の心理は移ろいやすく、日々変わっていくものです。日夜データマイニングを繰り返し、変わっていく意向を逃さないようにシミュレーションすることも必要です。大統領選挙では連日徹夜でデータマイニングが行われ、オバマ氏は見事に大統領選挙を勝ち抜きました。

進化しつつあるデータマイニング分析の技術

データマイニングは情報量の多い小売店などの分析にも使えます。

顧客と接することで生まれていく情報があります。

ECサイトなどでの莫大な売上が日々進化していきますが、統計的な予測を立てることは簡単です。ですがその情報がさらに複合化した場合はどうでしょうか。

天候、気温、チラシの配布状況などによってデータがより複雑化していくのですが、その多重層となったデータを分析することで整理し、新しい予測を生み出すこと。これがデータマイニングです。

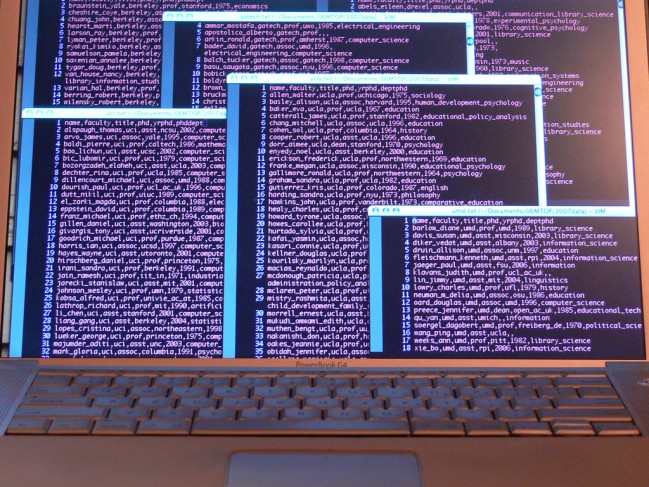

データマイニングシステムの導入によって、組み込まれているアルゴリズムを使って拘束にデータを処理し、莫大なデータの中から新しい価値を発見することとなります。

ただしデータマイニングを担当するマシンは、膨大なデータを処理するために高速なコンピュータを必要とします。

業務の具体的かつ豊富な知識も必要でしょう。現場の知識がないとデータマイニングはできないのです。

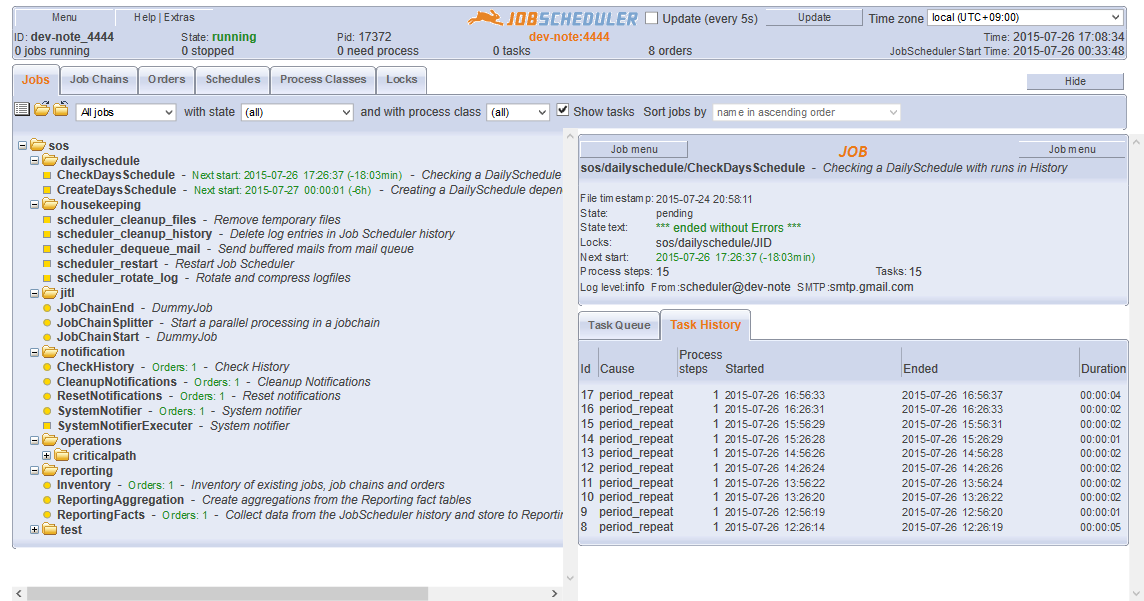

データマイニングシステムでは、グラフィカルにデータ分析が行えることが多いのです。ビジュアルでわかりやすく直感的な操作が可能です。

また簡易プログラム機能が搭載されている場合もあり、独自のアルゴリズムでパターン解析することも可能です。

ランダムに抽出、数量化、圧縮、分類などの加工をシステムで行います。

データのモデリングなどを行ってスコアリングし、優先順位や発生確率でソートすることも可能になります。

分析をシステムにまかせて、データの要因を設定するだけでいいのです。

データマイニングには10万レコード以上の情報が必要

少ないサンプルでは正確なデータが抽出できません。

データマイニングの対象になるには最低でも10万レコードが必要となるでしょう。

時間をかけて広範囲からあつめたデータで母集団が多いほど効果的に分析が可能となります。

煩雑で整理されてない膨大なデータから、新たな金脈を見つけるのがデータマイニングの技術です。分析に時間をかけて、思いもよらない情報を見つけましょう。

顧客の気持ちはうつろいやすく、日々変わっていきますので、データマイニングを繰り返し変わっていく顧客の意向を逃さないようにするのも大切です。

膨大なデータに翻弄されることなく、利用者はその分析の要因を左右する「要因が何か」だけを考えればいいのです。人力ではピックアップできないデータの中身をチェックして、限られたリソースの絞込みにだけ力を注げばいいのです。

クレジットカードの利用履歴から不正を検出する

身近で使われているデータマイニングの技術の一つに、クレジットカードの利用履歴から不正利用を検出する仕組みがあります。

クレジットカードはその人の履歴だけでなく、多くの人の膨大な購買記録が残っています。その中から、個人の嗜好、買い物パターンなどを分析するのです。

例えばオンラインゲームの決済に使っているカードを、外国で女性用下着を購入して不正が検出されたという出来事がありました。これは某芸能人が語っていたのですが、実際は奥様が旅行中にカードで決済する必要があり旦那さんのカードを借りたことが原因だそうです。

もちろん間違った不正検出もありますが、データは日々膨大に膨らんでゆきますので検出の精度はどんどんあがっていきます。

酔っ払ってカードを紛失し、その後不正利用された場合などはクレジットカードがロックされるのですがこれもデータマイニングの技術によって裏で不正検出のプログラムが動いています。

話題のニュースキュレーションアプリ

最近ではニュースキュレーションアプリが花盛りです。

中には上場する会社も出てきて、今勢いを増しています。

ニュースキュレーションアプリは、膨大にあるニュースの情報の中から、利用者の好みを選別し、データマイニング技術によってその人の好みにあったニュース、またソーシャルで拡散しやすいニュースなどを検出し、ピックアップしてくれるものです。

webで情報を検索するときには、これまでキーワードが必要でした。

検索をキーワードで行うのではなく、データマイニングの技術の応用によって自動でリコメンドしてくれるエンジン等が開発されています。

もちろん高度な専門知識が必要なものであり、ニュースキュレーションアプリには最新のデータマイニング技術が使われています。

オークションの不正検出システム

ネットオークションでも不正検出システムは使われています。

例えば低額商品を落札してばかりのアカウントが、突然高額の商品を大量出品した場合など、他人によるID乗っ取りの可能性が高くなります。

また評価を得ておいて詐欺出品をしているという可能性も考えられ、不正のIDとみなして運営がアカウントをロックします。

ローン審査システムへの応用

最近では金融機関の審査にもデータマイニング技術が使われています。

審査では、職業、勤続年数、年収、家族構成や過去の借入履歴などが属性として審査材料になります。

ただしそれだけでなく、金融機関が持っている莫大なデータの中から、似たような属性の人をピックアップし、その人の過去の返済率をチェックして審査に利用することが行われています。

金融機関は数多くの人の個人情報と信用履歴を持っていますので、その膨大なデータを統計的に判断し、同じような属性を持っている人がどのような行動パターンをして返済を計画的に行うのかをチェックしています。これも膨大なデータを利用したパターンの解析のひとつとなります。

大手SIerも参入

日本でも大手SIerがこのジャンルに参入しています。

膨大なデータ分析とハイスペックなコンピューター、豊富なアルゴリズムに対する知見が必要となりますので、やはり最先端のネットベンチャーか資金力のある大手SIerが参入しやすいジャンルとなっているでしょう。

各社がデータマイニングシステムを市場に投入し、よりビジュアル的に洗練された表現、経営判断、見える化、定量化、因果関係のネットワーク化、隠れた要因の発掘、シミュレーションの計測、シナリオの設定などが行えるサービスがどんどん市場に投入されていっています。

今後もデータマイニングの分野はより研究が進むと思われ、利用する企業も新たな価値を発掘していけることになるでしょう。

システムを開発する側はより高性能なアルゴリズムの開発、そして利用者側はより革新的なデータ要因を発掘できるようになるのです。

SNSなどの普及で日々膨大なデータが蓄積されていっているインターネットの情報を利用して、日々新しいサービスが開発されています。

本ブログは、Git / Subversionのクラウド型ホスティングサービス「tracpath(トラックパス)」を提供している株式会社オープングルーヴが運営しています。

エンタープライズ向け Git / Subversion 導入や DevOps による開発の効率化を検討している法人様必見!

「tracpath(トラックパス)」は、企業内の情報システム部門や、ソフトウェア開発・アプリケーション開発チームに対して、開発の効率化を支援し、品質向上を実現します。

さらに、システム運用の効率化・自動化支援サービスも提供しています。

”つくる情熱を支えるサービス”を提供し、まるで専属のインフラエンジニアのように、あなたのチームを支えていきます。

No Comments